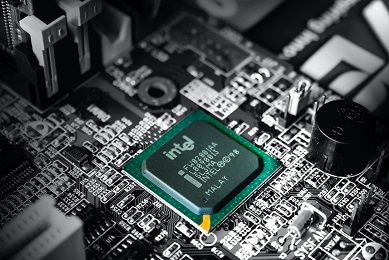

Intel, le géant des semi-conducteurs, a annoncé son ambition d’intégrer l’intelligence artificielle (IA) dans chacun de ses produits. Le CEO, Pat Gelsinger, déclare que l’avenir de l’IA réside dans les appareils eux-mêmes plutôt que dans le cloud. Cette stratégie vise à offrir des performances optimales en évitant les problèmes de latence, de bande passante et de coûts liés aux transferts de données vers le cloud. Pour concrétiser cette vision, Intel prévoit de lancer l’architecture Meteor Lake, comprenant une puce grand public équipée d’un processeur neuronal pour les tâches d’apprentissage automatique.

Cette annonce marque un changement significatif dans la vision d’Intel, qui avait initialement prévu d’intégrer les co-processeurs IA uniquement dans ses puces Ultra. Désormais, l’entreprise cherche à généraliser l’IA à tous ses produits pour saisir les opportunités du marché émergent.

Cette approche met également en évidence la compétition intense entre Intel et Nvidia, un leader dans le domaine des puces pour les opérations d’apprentissage automatique basées sur le cloud. En intégrant l’IA localement, Intel cherche à trouver sa place dans le marché de l’IA après avoir raté l’essor du mobile.

L’intégration de l’IA dans les appareils présente un avantage évident pour les utilisateurs qui n’ont pas toujours besoin de dépendre du cloud pour leurs besoins en intelligence artificielle. Les PC et autres dispositifs équipés de puces neuronales performantes permettront de réaliser des tâches d’IA complexes en temps réel sans recourir à une connexion au cloud.

Bien qu’Intel reste un acteur majeur de l’industrie des processeurs, cette nouvelle orientation vers l’IA intégrée est cruciale pour maintenir sa compétitivité face à des concurrents toujours plus agressifs dans le domaine de l’IA et du cloud computing.